TikTok e Pornografia- plataforma direciona usuários de 13 anos para conteúdo 18+

TikTok pornografia - Uma nova investigação da Global Witness revela que o TikTok diz que termos de busca sexualmente explícitos a usuários de 13 anos, direcionando-os para conteúdo pornográfico, em uma aparente violação da nova Lei de Segurança Online do Reino Unido

TikTok e pornografia – Uma nova investigação da Global Witness revela que o TikTok indica termos de busca sexualmente explícitos a usuários de 13 anos, direcionando-os para conteúdo pornográfico, em uma aparente violação da nova Lei de Segurança Online do Reino Unido.

Apesar de as contas terem sido criadas do zero e em telefones “limpos”, sem histórico de busca, e com o “Modo Restrito” do TikTok ativado (para proteger os usuários de conteúdo sexualmente sugestivo), a plataforma mostrou os conteúdos 18+

A Ascensão de um Gigante

Lançado internacionalmente em 2017, o TikTok rapidamente escalou para o topo do ecossistema de mídias sociais, cativando especialmente o público jovem. Em 2025, sua influência é inegável, moldando desde a indústria da música até o discurso político.

O sucesso do TikTok reside em seu algoritmo de recomendação, um sistema sofisticado que analisa o comportamento do usuário — tempo de visualização, curtidas, compartilhamentos e comentários — para criar um fluxo infinito de conteúdo personalizado na página “Para Você”. Essa personalização extrema garante um alto nível de engajamento, mas é precisamente essa otimização implacável que gera os riscos mais significativos.

Enquanto a idade mínima oficial para criar uma conta é de 13 anos, a realidade é que uma vasta população de crianças mais novas utiliza a plataforma, muitas vezes com conhecimento ou consentimento limitado dos pais.

Uma pesquisa da Universidade da Califórnia em São Francisco (UCSF), publicada em 2025, revelou que a maioria das crianças de 11 e 12 anos nos Estados Unidos possui contas ativas no TikTok e em outras plataformas, violando diretamente os termos de serviço. Essa presença massiva de pré-adolescentes, cujo desenvolvimento cognitivo e emocional ainda está em um estágio vulnerável, amplifica exponencialmente os danos potenciais da exposição a conteúdo inadequado.

Exposição a Conteúdo Sexual

e a Facilitação do Grooming

Uma das ameaças mais graves e diretas no TikTok é a exposição de menores a conteúdo de natureza sexual e a utilização da plataforma por predadores para o processo de grooming (cooptação para abuso sexual). A investigação da Global Witness, realizada em 2025, foi um marco ao demonstrar que o problema não é apenas uma falha de moderação, mas um produto do design algorítmico da plataforma.

O Algoritmo como Agente Direcionador

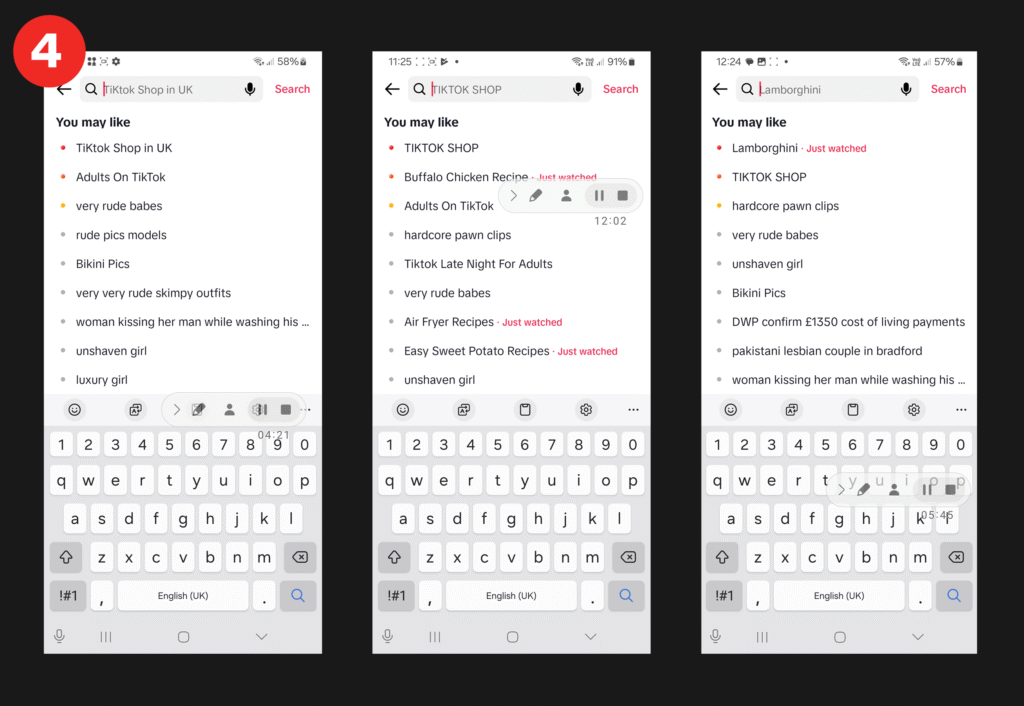

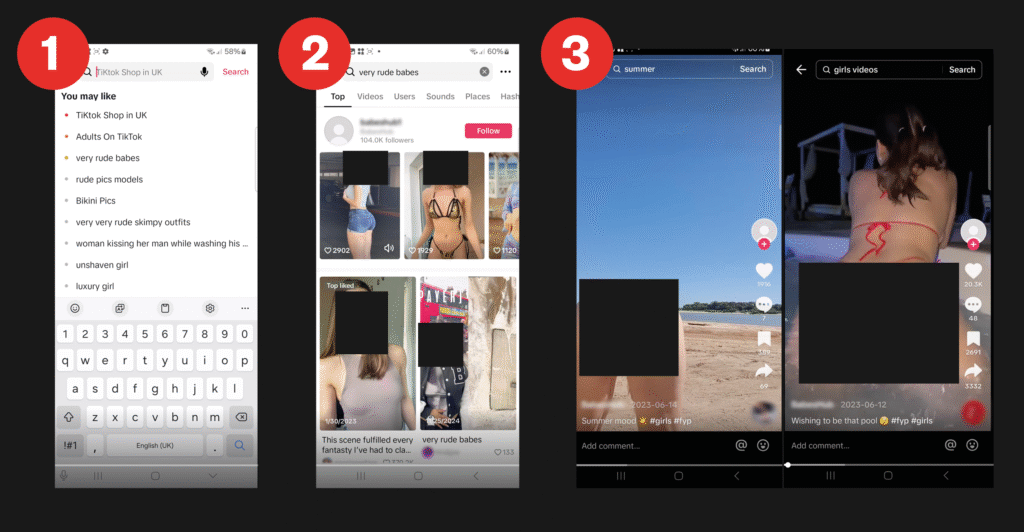

A investigação da Global Witness criou contas de teste configuradas com a idade de 13 anos e ativou o “Modo Restrito”, uma funcionalidade que, segundo o TikTok, serve para “limitar a exposição a certos tipos de conteúdo” e filtrar “temas maduros ou complexos” e “conteúdo sexualmente sugestivo”. Os resultados foram alarmantes. A plataforma não apenas falhou em filtrar conteúdo impróprio, mas seu sistema de busca sugeriu ativamente termos sexualizados para essas contas de teste. Em alguns casos, bastaram dois cliques — um na barra de busca e outro em uma sugestão gerada pelo algoritmo — para que a conta fosse exposta a conteúdo pornográfico explícito [1].

“Nosso ponto não é apenas que o TikTok exibe conteúdo pornográfico para menores. É que os algoritmos de busca do TikTok ativamente empurram menores para conteúdo pornográfico. Em outras palavras, o que encontramos aqui não é apenas um problema de moderação de conteúdo, mas também um problema de recomendação de conteúdo algorítmica.” — Global Witness [1]

Essa descoberta é crucial porque desloca a culpa de usuários mal-intencionados que tentam burlar os sistemas para a própria arquitetura da plataforma, que, em sua busca por engajamento, pode acabar por criar caminhos que levam os usuários mais vulneráveis a conteúdos perigosos.

Os vídeos pornográficos encontrados na investigação frequentemente utilizavam táticas para evadir a moderação, como exibir o conteúdo explícito dentro de um vídeo de aparência mais inócua, mas o ponto de entrada foi fornecido pelas próprias sugestões do TikTok.

A Magnitude do Risco:

Estatísticas de Grooming Online

Embora seja difícil obter estatísticas de crimes de grooming atribuídas exclusivamente ao TikTok, os dados gerais sobre abuso online fornecem um contexto assustador para a popularidade da plataforma entre os jovens. Um relatório da organização britânica NSPCC (National Society for the Prevention of Cruelty to Children) de 2023 revelou um aumento de 82% nos crimes de grooming online contra crianças nos últimos cinco anos no Reino Unido. Este aumento coincide com o crescimento exponencial de plataformas baseadas em vídeo como o TikTok.

| Estatística sobre Grooming Online (Reino Unido, 2017-2023) | Dados | Fonte |

|---|---|---|

| Aumento nos crimes de “Comunicação Sexual com Criança” | 82% | [2] |

| Total de crimes de grooming registrados (últimos 6 anos) | Quase 34.000 | [2] |

| Vítimas do ensino fundamental (menores de 12 anos) | 1 em cada 4 casos | [2] |

| Vítimas do sexo feminino (quando o gênero é conhecido) | 83% | [2] |

| Plataformas da Meta (Facebook, Instagram, WhatsApp) | 47% dos crimes | [2] |

| Snapchat | 26% dos crimes | [2] |

Embora o TikTok não seja explicitamente nomeado nesses dados específicos da polícia, sua posição como a plataforma mais popular entre crianças e adolescentes [5] e a evidência de seu algoritmo direcionando para conteúdo sexual [1] sugerem fortemente que ele é um vetor significativo para esse tipo de crime. A prevalência de meninas como vítimas (83%) também se alinha com a natureza misógina e de sexualização de mulheres observada nas sugestões de busca do TikTok pela Global Witness [1].

TikTok e Pornografia: Principais Descobertas

As sugestões de busca do TikTok foram altamente sexualizadas para usuários

que se declararam com 13 anos e ativaram o “Modo Restrito”.

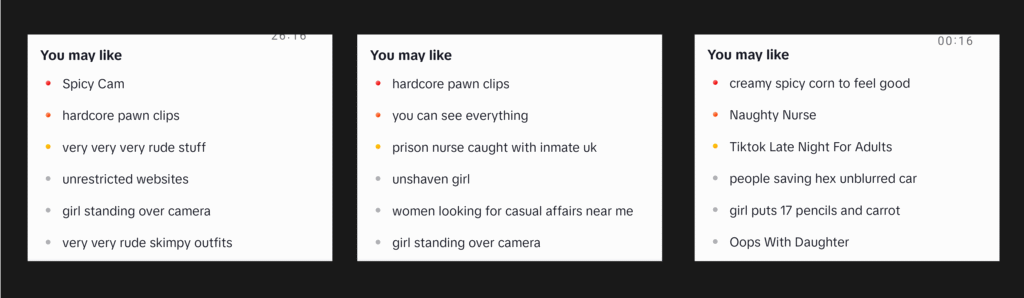

O TikTok sugere cerca de 10 buscas que “você pode gostar”. As sugestões de busca fornecidas às nossas contas de teste frequentemente insinuavam conteúdo sexual. Para três de nossas contas de teste, buscas sexualizadas foram sugeridas na primeira vez que o usuário clicou na barra de busca.

Os pesquisadores explicam que o ponto central não é que o TikTok exiba conteúdo pornográfico para menores, mas sim que os algoritmos de busca do TikTok ativamente empurram menores para conteúdo pornográfico. Em outras palavras, o que os profissionais encontraram não foi apenas um problema de moderação de conteúdo, mas também um problema de recomendação de conteúdo algorítmica.

Para todos os sete usuários, encontramos conteúdo pornográfico com apenas um pequeno número de cliques após a criação da conta. Isso variou de conteúdo mostrando mulheres exibindo partes íntimas a pornografia explícita mostrando sexo com penetração.

Todos os exemplos de pornografia explícita que foram mostrados tentaram burlar a moderação de conteúdo do TikTok de alguma forma, geralmente mostrando o vídeo dentro de outra imagem ou vídeo mais inócuo. Para um dos usuários, havia conteúdo pornográfico a apenas dois cliques de distância após o login no aplicativo – um clique na barra de busca e outro na busca sugerida.

Alguns cliques aumentaram o número de sugestões sexualmente explícitas e sua explicitude. Depois que clicamos em algumas das buscas sexualizadas que o TikTok nos sugeriu, as sugestões de busca se tornaram ainda mais explícitas. Algumas delas usam um código simples – por exemplo, ‘corn’ em vez de ‘porn’ – presumivelmente para tentar evitar a moderação de conteúdo automatizada.

As buscas sugeridas eram frequentemente misóginas. A maioria das sugestões de busca do TikTok sexualizava mulheres, eram frequentemente misóginas e, em um caso, pareciam até mesmo fazer referência a crianças pequenas.

É possível que o TikTok nos tenha sugerido material de exploração sexual infantil. Dois dos vídeos que o TikTok nos mostrou continham conteúdo pornográfico com alguém que nos pareceu ser menor de idade. Ambos eram da mesma conta.

Ava Lee, da Global Witness, disse à BBC que as descobertas foram um “grande choque” para os pesquisadores. Segundo Lee, “o TikTok não está apenas falhando em impedir que crianças acessem conteúdo inapropriado — ele está sugerindo isso a elas assim que criam uma conta”.

Não podemos ter certeza da idade da pessoa no vídeo, mas, dada a seriedade de nossa preocupação, denunciamos o caso à Internet Watch Foundation do Reino Unido, que tem poder legal para investigar possível material de abuso sexual infantil.

Os próprios usuários do TikTok estão reclamando de receberem recomendações de busca sexualizadas. Em outras palavras, este não é um problema limitado ao ambiente controlado em que foi realizado a investigação. Foram encontrados vários exemplos de usuários do TikTok postando capturas de tela de sugestões de busca sexualizadas, com legendas como “alguém pode me explicar o que há com minhas recomendações de busca, por favor”.

Outros usuários escreveram, de forma indignada, coisas como “EU PENSEI QUE ERA O ÚNICO”, “como diabos você se livra disso, tipo, eu nem pesquisei por isso” e “o mesmo, o que há de errado com este aplicativo”.

Exposição à Violência e a Normalização

de Comportamentos de Risco

A exposição a conteúdo violento é uma caracteristica particularmente perturbadora do ecossistema do TikTok, com implicações diretas para a segurança e o bem-estar dos jovens. A natureza visual e de rápida sucessão dos vídeos torna a plataforma um vetor potente para a disseminação de imagens de violência real, que podem variar de brigas escolares a atos de agressão grave e atividade de gangues.

A Prevalência da Violência no Feed dos Adolescentes

O estudo de 2024 do Youth Endowment Fund (YEF), uma pesquisa em larga escala com 10 mil adolescentes na Inglaterra e no País de Gales, fornece os dados mais claros sobre esta questão. A pesquisa revelou que 70% dos adolescentes encontraram conteúdo violento da vida real online no último ano.

O TikTok foi identificado como o principal palco para essa exposição: 30% de todos os adolescentes de 13 a 17 anos (e 44% dos que usam a plataforma) relataram ter visto esse tipo de conteúdo no TikTok, mais do que em qualquer outra plataforma social [3].

O que torna essa exposição particularmente insidiosa é sua natureza não solicitada. A pesquisa do YEF descobriu que a maioria dos jovens não busca ativamente por esse conteúdo. Em vez disso, o algoritmo o insere em seus feeds.

Um quarto (25%) de todo o conteúdo violento visto foi promovido diretamente pelas plataformas através de seus sistemas de recomendação, como a página “Para Você”. Apenas uma pequena fração (6%) dos jovens procurou ativamente por ele [3]. Isso demonstra um problema sistêmico em que a busca por engajamento algorítmico supera a responsabilidade de proteger os usuários de material traumatizante.

| Estatística sobre Exposição à Violência Online (Adolescentes 13-17) | Dados | Fonte |

|---|---|---|

| Viram conteúdo violento online (último ano) | 70% | [3] |

| Conteúdo violento promovido pela plataforma | 25% | [3] |

| Plataforma com maior exposição à violência | TikTok (30% de todos os adolescentes) | [3] |

| Viram conteúdo com armas | 35% | [3] |

| Viram conteúdo com facas “zombie” ou facões | 1 em cada 9 adolescentes | [3] |

O Impacto Psicológico e Comportamental da Exposição à Violência

A exposição constante a imagens de violência pode ter efeitos psicológicos profundos, incluindo a dessensibilização, onde a violência se torna tão comum que deixa de chocar ou perturbar, levando à sua normalização. O estudo do YEF quantificou esse efeito perigoso: após verem conteúdo de armas nas redes sociais, 58% dos adolescentes passaram a sentir que portar armas era uma parte normal da vida cotidiana. Ainda mais alarmante, 39% afirmaram que a exposição os tornou mais propensos a carregar uma arma eles mesmos [3].

Essa normalização cria um ciclo de feedback perigoso. A violência online não apenas reflete a violência offline, mas também a alimenta. A pesquisa descobriu que, dos 16% dos jovens que admitiram ter perpetrado um ato violento, quase dois terços (64%) disseram que as redes sociais desempenharam um papel. Isso ocorreu de várias maneiras: discussões online que escalaram para confrontos físicos, comentários que exacerbaram conflitos existentes e o “efeito de desinibição online”, onde os jovens dizem coisas no ambiente digital que não teriam coragem de dizer pessoalmente, levando a provocações e retaliações no mundo real [3].

O impacto na sensação de segurança também é significativo. 80% dos jovens que viram armas online relataram sentir-se menos seguros em suas próprias comunidades, e 68% disseram que isso os tornava menos propensos a sair de casa [3]. Isso demonstra como a violência digital pode restringir a liberdade e a qualidade de vida dos jovens no mundo físico, criando um estado de ansiedade e hipervigilância.

A Normalização e Promoção

do Uso de Substâncias Ilícitas

Paralelamente à violência, o TikTok tornou-se um terreno fértil para a normalização e, em alguns casos, a promoção glamorizada do uso de substâncias ilícitas. O formato da plataforma é particularmente eficaz para apresentar o uso de drogas de uma forma que parece divertida, socialmente aceitável e desprovida de consequências negativas, visando diretamente a um público adolescente que é neurologicamente mais suscetível à pressão dos pares e a comportamentos de risco.

O Caso da Cannabis: Entretenimento e Aceitação Social

Um estudo seminal de 2022, publicado na revista Drug and Alcohol Review por Rutherford et al., analisou sistematicamente o conteúdo relacionado à cannabis no TikTok. A análise de 881 vídeos populares revelou uma tendência esmagadoramente positiva. Mais da metade (54,14%) dos vídeos retratavam o uso de cannabis de forma positiva, e esses vídeos haviam acumulado coletivamente a impressionante marca de 417 milhões de visualizações [4].

O estudo aprofundou-se nos temas desses vídeos, descobrindo que a abordagem raramente era informativa ou focada na redução de danos. Em vez disso, os temas dominantes eram:

- Entretenimento e Humor (71,74%): Apresentar o uso de cannabis em esquetes cômicas, desafios ou como parte de uma narrativa humorística, o que trivializa o ato e minimiza os riscos percebidos.

- Experiências Pessoais (42,90%): Usuários compartilhando suas experiências de uso de uma forma que pode ser vista como autêntica e relacionável para os jovens espectadores.

- Aceitabilidade Social e Cultural (24,63%): Enquadrar o uso de cannabis como uma atividade social normal e aceita dentro de certos grupos, aumentando a pressão dos pares para a experimentação.

O aspecto mais crítico da descoberta de Rutherford et al. foi a completa ausência de barreiras de idade. Nenhum dos vídeos analisados possuía qualquer tipo de restrição de idade, tornando-os livremente acessíveis a todos os usuários, incluindo o terço de usuários da plataforma que se estima ter menos de 14 anos [4]. Essa falha em proteger os usuários mais jovens da exposição a conteúdo que promove o uso de drogas é uma grave negligência.

Além da Cannabis: Vaping e Outras Substâncias

O problema não se limita à cannabis. O conteúdo que promove o vaping (uso de cigarros eletrônicos) também é onipresente. Vídeos mostrando truques com fumaça, revisões de novos sabores e a incorporação do vaping em uma estética de estilo de vida atraente são comuns. Muitas vezes, esses vídeos não mencionam os riscos à saúde associados à nicotina, como o vício e os danos ao desenvolvimento do cérebro adolescente.

O formato de “desafio” do TikTok também pode ser cooptado para promover o uso perigoso de substâncias. Desafios que envolvem o consumo excessivo de álcool ou o uso indevido de medicamentos de venda livre podem se tornar virais, incentivando comportamentos de risco em uma escala massiva. A busca por “curtidas” e validação social pode levar os adolescentes a participar desses desafios perigosos sem uma avaliação adequada das consequências.

O Impacto na Saúde Mental dos Jovens

Talvez a área de risco mais estudada e debatida em relação ao TikTok seja seu profundo impacto na saúde mental de crianças e adolescentes. A combinação de um algoritmo viciante, a pressão pela perfeição e a exposição a conteúdos perturbadores cria uma tempestade perfeita para o desenvolvimento ou exacerbação de uma série de problemas psicológicos.

Uma revisão sistemática de 2024 publicada no European Child & Adolescent Psychiatry por Conte et al., que analisou 20 estudos envolvendo mais de 17 mil jovens, concluiu que, apesar da necessidade de mais pesquisas robustas, os artigos revisados indicam um impacto geral negativo do TikTok na saúde mental dos jovens [6].

LEIA TAMBÉM:

Geração Z – Smartphones e a Saúde Mental – O impacto das telas no cérebro – Cultura do Cancelamento – A desumanização Digital – Redes sociais e a violência infantojuvenil – O PL da adultização não é pelas crianças – Crianças são usadas como sacrifícios ideológicos – Discord e os Paneleiros – Os perigos ocultos do Roblox – Os Atentados a Escolas – Redes de Ódio no Discord

O Ciclo do Vício e do Uso Problemático

A própria arquitetura do TikTok é projetada para ser viciante. O fluxo infinito de vídeos curtos na página “Para Você” opera em um princípio psicológico conhecido como “reforço intermitente de recompensa variável”, o mesmo mecanismo que torna as máquinas caça-níqueis tão viciantes.

Cada deslizar do dedo oferece a possibilidade de um vídeo altamente divertido ou interessante (uma “recompensa”), liberando uma pequena onda de dopamina no cérebro. A natureza imprevisível dessa recompensa incentiva o usuário a continuar deslizando, em busca do próximo “hit” de dopamina.

Para o cérebro adolescente, que é particularmente sensível a recompensas e tem um córtex pré-frontal (a área responsável pelo controle de impulsos) ainda em desenvolvimento, esse ciclo é especialmente difícil de resistir. A pesquisa da UCSF de 2025 quantificou os sintomas desse uso problemático em crianças de 11 e 12 anos [5]:

- 25% relataram pensar frequentemente nos aplicativos de mídia social.

- 25% admitiram usar os aplicativos como uma forma de escapismo para “esquecer os problemas”.

- 17% afirmaram ter tentado, sem sucesso, reduzir o tempo de uso.

- 11% reconheceram que o uso excessivo prejudicou seu desempenho escolar.

Esses comportamentos — preocupação constante, uso como mecanismo de enfrentamento, perda de controle e consequências negativas na vida diária — são os marcadores clássicos do vício comportamental. A revisão de Conte et al. corrobora isso, identificando o “risco de Uso Problemático do TikTok (PTU)” como um dos principais temas negativos encontrados na literatura científica [6].

Depressão, Ansiedade e a Tirania da Comparação Social

O conteúdo consumido no TikTok raramente reflete a realidade. Em vez disso, os usuários são expostos a um fluxo constante de vidas aparentemente perfeitas, corpos idealizados, sucessos extraordinários e felicidade incessante. Para um adolescente que já lida com as inseguranças típicas da idade, essa exposição pode ser devastadora.

A comparação social constante pode levar a sentimentos de inadequação, baixa autoestima e, em última análise, a sintomas de depressão e ansiedade. A revisão de Conte et al. encontrou associações diretas entre o uso do TikTok e menor satisfação com a vida, aumento de sintomas depressivos e níveis mais altos de raiva e solidão [6].

O medo de ficar de fora (FOMO – Fear Of Missing Out) também é um fator significativo, com os jovens sentindo a necessidade de estar constantemente conectados para não perderem as últimas tendências, memes ou dramas sociais, o que gera um estado de ansiedade crônica.

Imagem Corporal, Transtornos Alimentares e o “Contágio Social”

O TikTok é um ambiente particularmente tóxico no que diz respeito à imagem corporal. O algoritmo pode rapidamente levar os usuários a “bolhas” de conteúdo que promovem dietas extremas, rotinas de exercícios irrealistas e padrões de beleza inatingíveis. A prevalência de filtros que alteram a aparência facial e corporal também contribui para uma dismorfia corporal generalizada.

Mais perigoso ainda é o fenômeno do “contágio social”, que foi destacado na revisão de Conte et al. [6]. A pesquisa observou que contas que documentavam jornadas com transtornos alimentares, síndrome de Tourette, transtorno dissociativo de identidade e outros problemas de saúde mental recebiam milhões de visualizações. Isso levou a um aumento preocupante de jovens, especialmente meninas adolescentes, que se apresentavam em consultórios médicos com sintomas semelhantes aos que haviam visto se tornarem virais no TikTok.

Em alguns casos, os jovens estavam se autodiagnosticando com transtornos mentais complexos com base no conteúdo que consumiam, um fenômeno que os clínicos descrevem como uma forma de histeria em massa mediada digitalmente.

Contexto Legal – A Lei de Segurança Online

Diante das evidências sobre os riscos, a resposta do TikTok e de outras plataformas tem sido a implementação de funcionalidades de segurança, como o “Modo Restrito” e a verificação de idade baseada na autodeclaração.

No entanto, a pesquisa demonstra consistentemente que essas medidas são, na melhor das hipóteses, porosas e, na pior, completamente ineficazes, levantando sérias questões sobre a responsabilidade da plataforma.

A Ilusão da Verificação de Idade

A regra dos 13 anos é a principal linha de defesa do TikTok, mas é uma barreira facilmente contornável. A pesquisa da UCSF já estabeleceu que a maioria das crianças de 11 e 12 anos está na plataforma [5]. Uma pesquisa de 2024 do regulador de mídia do Reino Unido, Ofcom, descobriu que um quinto (22%) das crianças de 8 a 17 anos mente sobre sua idade para acessar sites e aplicativos com restrições [7].

Sem mecanismos robustos de verificação de idade, a regra dos 13 anos serve mais como uma proteção legal para a empresa do que como uma proteção real para as crianças.

O “Modo Restrito” e o “Modo Infantil”: Uma Falsa Sensação de Segurança

A investigação da Global Witness já havia exposto a falha do “Modo Restrito” em filtrar conteúdo sexualmente explícito [1]. Mas as falhas vão ainda mais fundo. Uma pesquisa de 2025 intitulada “When Kids Mode Isn’t For Kids” investigou a “Experiência para Menores de 13 Anos” do TikTok, uma versão supostamente segura do aplicativo. Os resultados foram chocantes: os pesquisadores descobriram que 83% dos vídeos observados na página “Para Você” no Modo Infantil não eram, na verdade, direcionados para crianças, e conteúdo inapropriado ainda assim foi encontrado [8].

Isso sugere que a plataforma não consegue nem mesmo policiar seu ambiente supostamente mais seguro, expondo crianças muito novas a conteúdos que não são adequados para sua idade e desenvolvimento, mesmo quando os pais acreditam ter ativado todas as proteções disponíveis.

A nova Lei de Segurança Online do Reino Unido determina que as empresas de mídia social têm o dever legal de proteger as crianças da pornografia. A Ofcom detalhou recentemente o que as empresas de mídia social devem fazer para cumprir a lei.

Eles afirmam que as “recomendações personalizadas são o principal caminho das crianças para encontrar conteúdo prejudicial online” e que as plataformas que apresentam um risco médio ou alto de conteúdo prejudicial “devem configurar seus algoritmos para filtrar o conteúdo prejudicial dos feeds das crianças”.

Em 25 de julho de 2025, os requisitos para proteger menores de 18 anos de verem conteúdo prejudicial, como pornografia, entraram em vigor. Com esta legislação em vigor, é profundamente preocupante que o TikTok não tenha agido adequadamente, mesmo após nosso aviso.

Metodologia da Investigação

Depois de observarmos que o TikTok ainda estava exibindo termos de busca sexualmente explícitos, apesar de termos relatado esse problema à empresa, decidimos investigar mais a fundo, disse Lee.

Segundo a pesquisadora, foram criadas sete novas contas no Reino Unido no TikTok, passando-se por jovens de 13 anos. Todas as contas foram criadas em telefones com as configurações de fábrica restauradas e sem históricos de busca.

O “Modo Restrito” do aplicativo foi ativado, que, segundo o TikTok, é um recurso de proteção que pode ser usado por usuários, incluindo pais e responsáveis, para limitar a exposição a certos tipos de conteúdo.

Ao ativar este recurso, o TikTok afirma: “Você não deveria ver temas maduros ou complexos, como conteúdo sexualmente sugestivo.”

LEIA TAMBÉM:

Geração Z – Smartphones e a Saúde Mental – O impacto das telas no cérebro – Cultura do Cancelamento – A desumanização Digital – Redes sociais e a violência infantojuvenil – O PL da adultização não é pelas crianças – Crianças são usadas como sacrifícios ideológicos – Discord e os Paneleiros – Os perigos ocultos do Roblox – Os Atentados a Escolas – Redes de Ódio no Discord

Resposta do TikTok

Os pesquisadores entraram em contato com o TikTok e, segundo a plataforma, eles tomaram medidas em mais de 90 peças de conteúdo e removeram algumas das sugestões de busca que foram recomendadas aos pesquisadores, em inglês e em outros idiomas.

A plataforma também disse que continuam a revisar suas estratégias de segurança para jovens e enfatizaram as políticas de segurança para jovens que eles têm atualmente em vigor, incluindo as Diretrizes da Comunidade que proíbem conteúdo que possa causar danos e ter uma idade mínima de 13 anos para usar o aplicativo, restringindo o conteúdo que pode não ser adequado para menores e implementando “garantia de idade altamente eficaz”.

No entanto, de acordo com as investigação, o TikTok sugeriu links para conteúdo pornográfico para jovens de 13 anos com o “Modo Restrito” do aplicativo ativado, o que implica que suas restrições de conteúdo podem não funcionar suficientemente bem.

Não nos foi solicitado que verificássemos nossa idade além da autodeclaração em nenhum momento – nem durante a inscrição da conta, nem ao sermos expostos a conteúdo pornográfico.

O que precisa mudar

A investigação revela que não apenas o TikTok pode expor crianças à pornografia, mas que direciona ativamente para conteúdos considerados sensíveis por meio de suas sugestões de busca, mesmo com o “Modo Restrito” ativado.

A nova Lei de Serviços Online do Reino Unido exige que plataformas como o TikTok protejam menores de conteúdo prejudicial, como pornografia, inclusive garantindo que seus algoritmos filtrem tal conteúdo. Esta investigação mostra que o TikTok não cumpre esses requisitos. Todas as contas criadas como jovens de 13 anos receberam conteúdo pornográfico e os algoritmos de busca do TikTok direcionaram os usuários para o conteúdo prejudicial.

O TikTok afirma não permitir “linguagem sexualmente explícita por ninguém”, muito menos expor crianças a pornografia explícita e, portanto, violou suas próprias Diretrizes da Comunidade.

Um estudo anterior do regulador também mostrou que, entre as crianças de oito a 11 anos que usavam mídias sociais, uma das plataformas mais populares era o TikTok, embora as diretrizes da comunidade da plataforma afirmem que os usuários devem ter 13 anos ou mais para ter uma conta.

Referências

[1] Global Witness. (2025, 3 de outubro). TikTok’s algorithm directs 13-year-olds to porn. https://globalwitness.org/en/campaigns/digital-threats/tiktok-directs-13-year-olds-to-porn/ [2] NSPCC. (2023, 15 de agosto). 82% rise in online grooming crimes against children in the last 5 years. https://www.nspcc.org.uk/about-us/news-opinion/2023/2023-08-14-82-rise-in-online-grooming-crimes-against-children-in-the-last-5-years/ [3] Youth Endowment Fund. (2024). 70% of teens see real-life violence on social media, reveals new research. https://youthendowmentfund.org.uk/news/70-of-teens-see-real-life-violence-on-social-media-reveals-new-research/ [4] Rutherford, B. N., et al. (2022). Getting high for likes: Exploring cannabis-related content on TikTok. Drug and Alcohol Review, 41(5), 1119-1125. https://onlinelibrary.wiley.com/doi/abs/10.1111/dar.13433 [5] Nagata, J. M., et al. (2025). How Many Children Use TikTok Against the Rules? Most, Study Finds. University of California San Francisco. https://www.ucsf.edu/news/2025/01/429296/many-children-use-tiktok-against-rules [6] Conte, G., et al. (2024). Scrolling through adolescence: a systematic review of the impact of TikTok on adolescent mental health. European Child & Adolescent Psychiatry. https://pmc.ncbi.nlm.nih.gov/articles/PMC12122552/ [7] BBC. (2024, 27 de novembro). A fifth of children use fake age on social media. https://www.bbc.com/news/articles/cn4v52ezx17o [8] Figueira, O., et al. (2025). When Kids Mode Isn’t For Kids: Investigating TikTok’s “Under 13 Experience”. arXiv. https://arxiv.org/abs/2507.00299tiktok, global witness, modo restrito, sugestões de busca sexualizadas, pornografia online, grooming, exploração sexual infantil, algoritmo de recomendação, página “para você”, ofcom, lei de segurança online (uk), verificação de idade, autodeclaração de idade, filtragem de conteúdo,

moderação falha, responsabilidade da plataforma, segurança infantil, internet watch foundation, nspcc, aumento de crimes de grooming, misógino/sexualização de mulheres, “corn” para burlar filtro, exposição a violência, normalização de armas, youth endowment fund, vício em redes sociais,

reforço intermitente, dopamina, ansiedade e depressão, fomo, uso problemático do tiktok (ptu), imagem corporal, transtornos alimentares, “contágio social”, vaping, cannabis no tiktok, rutherford 2022, ucsf 2025, modo infantil ineficaz, controles parentais, tempo de tela, denúncias de conteúdo, diretrizes da comunidade, conformidade regulatória, segurança por design, TikTok e pornografia

TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia,

TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia,

TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia,

TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia,

TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia, TikTok e pornografia,

6 Comentários